시작하며

이전에 진행했던 프로젝트에 대해 정리해보려고 한다. 혼자서 파일과 문서형식으로 저장해두었었지만, 공유하는 삶을 살아보고자 모든 프로젝트를 차근차근 업로드해볼 예정이다 :)

학부생 수준에서 진행한 프로젝트이기에, 대단하지도 뛰어나지도 않는다.

단지 유명한 데이터셋을 가지고 내가 가진 기술을 증명해보기 위해 진행했던 프로젝트가 대부분이다.

혼자 진행한 것이 아닌, 팀원들과 진행한 것으로 자세한 전체 코드에 대한 업로드는 하지 않을 예정이고

내가 담당했던 부분 부분만 업로드할 예정이다 ;)

그래도! 지나가시다가 혹시 읽어보시고, 잘못된 부분, 개선의 여지가 있는 부분, 문제점 등에 대한 모든 피드백은 환영입니다. 많은사람들에게 배우고싶어요!

프로젝트 주제

TM(텔레마케팅)이 상품가입으로 이어지는 고객군 분석

주제 선정 배경

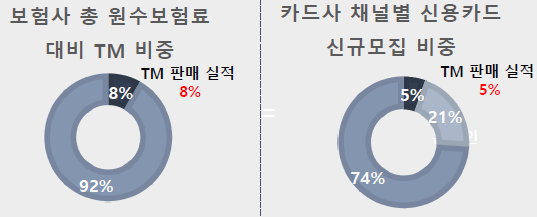

TM(텔레마케팅)의 판매 실적은 보험사 / 카드사에서 각각 8%와 5%를 차지하므로 무시하지 못하는 실적을 달성하고 있는 것을 확인해 볼 수 있다. 즉, 금융권, 보험사, 통신사 등 다양한 산업의 기업에서 TM을 활용하여 고객 영업을 하는 중이고, 수익을 꾸준히 올리고 있는 것으로 판단했다.

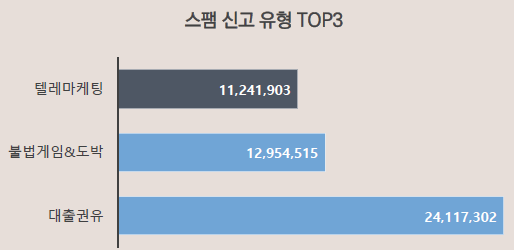

하지만 대부분의 사람들은 TM 전화를 스팸 전화로 인식하고 있다. 따라서 기업에게는 꼭 필요한 마케팅 전략이지만, 고객의 대부분은 TM 전화 수신을 원치 않는다고 판단할 수 있었다.

결론적으로, 기업의 입장에서는 TM 전화를 받았다가 끊어버리거나, 신고하는 고객군을 제외한 최소한의 고객군을 선정하여 TM 마케팅을 진행해야함을 알 수 있다.

전체 고객군 보다는 영업 성공률이 높은 특정 타겟을 대상으로 TM을 진행하여 TM 투자 비용을 절감할 수 있는 방안을 찾아보고자 이런 프로젝트를 진행하게 되었다.

프로젝트의 목적

TM이 상품 가입으로 이어지는 고객군의 특성을 분석하여 어떤 고객에게 TM을 수행해야하는 것이 타당할지 예측하고, 이를 통해 TM의 효과를 높이고 투자 비용은 최소화하는 방법을 모색한다.

활용 데이터

UCI의 은행 텔레마케팅 데이터

활용 알고리즘

Naive Bayes / Decision Tree / CART / Random Forest / SVM / Logistic Regression / ANN

Step1. 데이터 탐색

1. poutcome - previous 의 관계

- 이전 TM이 성공한 고객은 TM이전 연락 횟수가 적으면 상품 가입으로 이어질 확률이 높다.

- 이전 TM 성공 유무가 불분명한 경우는 TM 이전 연락 횟수와 관계 없이 대체로 상품을 가입하지 않는다.

2. poutcome - campaign 의 관계

- 이전 TM이 성공한 경우 TM횟수가 적어야 상품가입으로 이어진다.

- 이전 TM의 성공유무가 불분명한 경우 TM횟수가 많으면 상품을 가입하지 않는다.

- 이전 TM이 성공도 실패도 아니라면, 횟수가 너무 많거나 적을 때 상품을 가입하지 않는다.

3. poutcome - pdays 의 관계

- 이전 TM이 성공한 고객에게 짧은 간격을 두고 다시 TM을 수행하면 상품 가입이 실패로 이어질 확률이 크다.

- 이전 TM이 실패한 고객에게 한참 후에 다시 TM을 수행하면 상품 가입에 성공할 가능성이 크다.

Step2. 변수 타입 변경

종속변수를 범주형 변수로 바꿔주는 과정을 수행

setwd('C:\\Users\\Desktop')

bank<-read.csv('bank_term_deposit.csv')

str(bank)

#종속변수를 범주형 변수로 바꿈

bank$y<-factor(bank$y)

summary(bank)

str(bank)

#1행 & age 변수 삭제

bank<-bank[,-1:-2]

str(bank)데이터를 bank 변수에 저장한 후, y값을 범주형 변수로 변형해주었다.

그리고 분석에 필요 없다고 생각되는 age 변수와, 첫번째 행은 삭제해 주었다.

step3. 데이터 분할 및 오버샘플링

#데이터 분할

set.seed(123)

index<-sample(3,nrow(bank),replace=TRUE,prob=c(0.5,0.25,0.25))

bank.train<-bank[index==1,]

bank.validation<-bank[index==2,]

bank.test<-bank[index==3,]

table(bank.train$y)

#오버샘플링

library(ROSE)

data.balanced.over<-ovun.sample(y~., data=bank.train,

p=0.5, seed=1,

method='over')$data

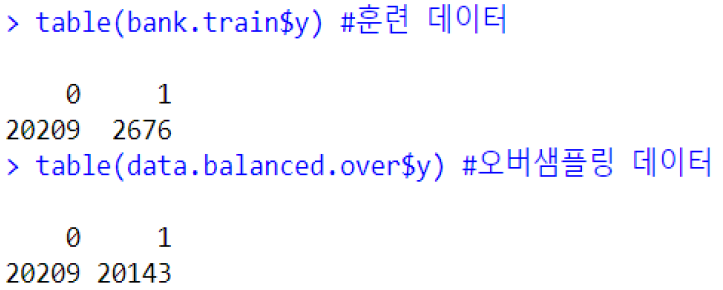

table(bank.train$y) #훈련 데이터

table(data.balanced.over$y) #오버샘플링 데이터오버샘플링을 진행하지 않았던 프로젝트의 초기 단계에서는, Accuracy가 상당히 낮고, 데이터의 갯수가 충분하지 못하다고 생각되어 오버샘플링을 진행하게 되었다.

Step3. 모델링

1. Decision Tree

#Decision tree _ data.balanced.over

DT.bank2<-C5.0(y ~ ., data = bank.train)

DT.bank.predict2<-predict(DT.bank2, bank.validation)

DT.bank.table2<-table(bank.validation$y, DT.bank.predict2)

DT.bank.table2

paste('decision tree accuracy2 :',

(DT.bank.table2[1,1]+DT.bank.table2[2,2])/sum(DT.bank.table2))

2. CART

# CART

bank.cart = rpart(y~., data=bank.train, control = rpart.control(minsplit=10))

print(bank.cart)

plot(bank.cart)

text(bank.cart,use.n = T)

print(bank.cart$cptable)

opt=which.min(bank.cart$cptable[,"xerror"])

cp=bank.cart$cptable[opt,"CP"]

bank_prune=prune(bank.cart,cp=cp) #가지치기

print(bank_prune)

plot(bank_prune)

text(bank_prune)

bank.prune_pre=predict(bank_prune, newdata = bank.validation, type = 'class')

bank.prune_pre

bank.prune_tab = table(bank.validation$y,bank.prune_pre)

bank.prune_tab

bank.prune_tab

paste('CART accuracy :',

(bank.prune_tab[1,1]+bank.prune_tab[2,2])/sum(bank.prune_tab))

3. RandomForest

3-1) CV를 활용한 파라미터 튜닝 진행

library(cvTools)

library(foreach)

set.seed(123); K=10 ;R=3

cv <- cvFolds(Nrow(bank), K=K, R=R)

grid <- expand.grid(ntree = c(10, 100, 200), .combine = rbind) %do% {

foreach(r = 1:R, .combine = rbind) %do% {

foreach(k=1:K, .combine = rbind) %do% {

validation_idx <- cv$subsets[which(cv$which == k), r]

train <- bank[-validation_idx, ]

validation <- bank[validation_idx, ]

#모델훈련

m <- randomForest(y~., data = train, ntree=grid[g, "ntree"],

mtry = grid[g, "mtry" ]

#예측

predicted <- predict(m, newdata = validation)

#성능평가

accuracy <- sum(predicted == validation $ y) / NROW(predicted)

return(data.frame(g=g, accuracy = accuracy))

}

}

}

result

library(plyr)

ddply(result, .(g), summarize, mean_accuracy = mean(accuracy))

grid[c(6), ]- ntree = 200, myry = 4 일 때 정확도가 90.83%로 가장 높음

3-2) 모델링

#Random Forest

install.packages("randomForest")

library(randomForest)

RF.bank<-randomForest(y~., data=bank.train)

RF.bank.predict<-predict(RF.bank, bank.validation)

RF.bank.table<-table(bank.validation$y,RF.bank.predict)

paste('random forest accuracy :',

(RF.bank.table[1,1]+RF.bank.table[2,2])/sum(RF.bank.table))

4. Logistic Regression

#Logistic Regression

logit.bank<-glm(y~., family=binomial, data=bank.train)

logit.bank.predict<-(predict(logit.bank,bank.validation, type="response")>=0.5)

logit.bank.table<-table(bank.validation$y, logit.bank.predict)

logit.bank.table

paste('logistic regression accuracy :',

(logit.bank.table[1,1]+logit.bank.table[2,2])/sum(logit.bank.table))

5. SVM

#SVM

library(e1071)

#numeric 변수 normalization

normalize<-function(x){

return((x-min(x))/(max(x)-min(x)))

}

bank.train$age<-normalize(bank.train$age)

bank.train$balance<-normalize(bank.train$balance)

bank.train$duration<-normalize(bank.train$duration)

head(bank.train)

bank.validation$age<-normalize(bank.validation$age)

bank.validation$balance<-normalize(bank.validation$balance)

bank.validation$duration<-normalize(bank.validation$duration)

SVM.bank<-svm(y~age+balance+duration+campaign+pdays+previous, data=bank.train)

SVM.bank.predict<-predict(SVM.bank,bank.validation)

SVM.bank.table<-table(bank.validation$y, SVM.bank.predict)

SVM.bank.table

step4. 모델 선정

앞서 Accuracy 가 현저히 낮아서, 오버샘플링을 하고 다시 모델링을 진행했다고 언급했다.

따라서 최종적으로는,

0.928의 Accuracy, 0.808의 recall 값을 도출해낸, Logistic Regression 모델을 최종 모델로 선정했다.

step7. ROC 커브 확인

#ROC curve를 통한 최적 cut-off value 확인

ROC = roc(bank.validation$y, pred.bin3)

plot.roc(ROC, col = 'red', print.auc = FALSE, max.auc.polygen=True,

print.thres=True, prin.thres.pch=19, print.thres.col="black",

auc.polygon=True, auc.polygon.col = "#D1F2EB")

cut-off value가 0.5일 때 가장 좋은 성능을 보임.

0.5 이상이면 1로 분류하도록 하면 될 것이라고 판단했다.

step6. 성능 확인

#Lift Chart

pr <- prediction(pred.test, bank.test$y)

model.lift2 <- performance(pr, "lift", "rpp")

with.pragh(); plot(model.lift2, col = "red")

테스트 데이터에 대한 Lift Chart를 출력해 보았는데, 최상위 확률을 가진 고객에게는 약간 불안정하지만 점점 안정되게 올바르게 분석하고 있음을 알 수 있다.

기대효과

1. 전체 고객군 중 일부만 추출하더라도 상품 가입 가능성이 높은 고객을 선별 가능하다.

2. 모든 고객에게 하는 일괄적인 마케팅보다 비용이 크게 감소할 것이다.

3. 재현률(recall)을 높임으로써 낮은 정확도 대비 높은 수익을 기대할 수 있을 것이다.

이 프로젝트의 한계점

1. 고객별 상품 가입의 규모를 고려하지 않았다.

2. 정밀도 (Precision)이 낮아 선택된 고객 중 가입의사가 없는 고객이 있다.

3. 오버샘플링한 데이터이기 때문에 실제와 다를 수 있다.

마치며

학부생때 진행했던 코드르 보니 정확하지 않은 변수명도 많고, 코드가 좀 어지럽다. 더불어 분석을 제대로 시행했다 하는 자신(?)또한 없다. 하지만 이 시점에 다시 정리해봄으로써 나에게 무엇이 부족한지, 무슨 공부가 더 필요한지에 대해 찾아볼 수 있었다. 앞으로는 통계공부를 조금 더 하고, 파생변수를 생성한다던지, 다른 앙상상블모델을 활용한다던지해서 정확도를 올리는 방법을 모색해 볼것이다.

'AI study > potato's PJT (in dongguk)' 카테고리의 다른 글

| [Speech AI] 청각장애인을 위한 사용자 맞춤형 소리 분류 시스템 개발 (13) | 2021.04.29 |

|---|---|

| [추천시스템] 영화 평점 데이터로 협업필터링 추천시스템 (Collaborative Filtering) 구현 (2) | 2021.04.29 |

| [Data Science] 미식축구 경기 네트워크 분석 및 링크 예측 (0) | 2021.04.29 |

| [NLP] 특허 데이터로 Topic Modeling을 진행해보자 (0) | 2021.04.29 |

| [인턴] R의 magick 패키지를 활용하여 이미지 색상 추출하기 (0) | 2021.03.12 |