시작하며

2019년 AI관련 수업을 수강하며 computer vision에 대해서 배웠다. 이 이후, 비정형 데이터에 대한 욕심이 생기기 시작했으며 3학년 주제에 4학년이 졸업프로젝트로 나가는 학술대회에 참여를 도전하게 되었다. 4학년의 졸업프로젝트는 기업연계 프로젝트로 실제로 기업 현직자들과 함께하는 프로젝트들 이었다.

이 사건을 계기로, 많은 대회에 참여하는 용기를 얻게된다 :) 또, 끈기있게 도전하고 결과물을 만족스럽게 뽑아낸 결과 내 인생 처음으로 큰 대회에서 상을 받게 된다. 그 좋은 기억을 떠올리며, 우리팀이 만들었던 시스템을 리뷰해보려고 한다 .

1. 프로젝트 개요

1.1 프로젝트 주제 선정 배경

청각장애인이 소리를 듣지못해 격는 문제 정의

① 위험 감지 어려움

- 차 경적소리, 사이렌 소리 등 위험 감지 요소가 될 수 있는 소리를 파악하지 못하여 위험 노출 가능성이 높다.

- 실제 사례) 청각장애인의 현실과 요구사항

‘보청기’뿐인 청각장애보조기 시장에 새바람 일으킨 男

“넌 왜 맨날 벽에 붙어다니냐?”어느 날 선배가 내게 물었다. “뒤에서 차가 빵빵 거리는 걸 들을 수 없으니까요. 한 번은 기다리던 운전자가 세게 박아서 허리가 나갈 뻔한 적도 있고요.” 보

brunch.co.kr

② 청각 보조기기의 높은 가격

- 특정 소리를 감지하기 위해 높은 가격의 청각보조기기를 구매해야 한다. 정부 지원금 제도가 있으나 이를 지원 받지 못하는 장애인이 다수였다.

- 실제 사례) 보청기 보조금의 현실

‘최대 131만원’ 보청기 보조금, 절차와 자격조건 TIP

① 최대 131만원까지 지원 =우선 보청기 보조금 대상자는 2~6등급 청각장애판정을 받은 난청인에 한하며, 등급별 가격 차이 없이 보청기 지원금 최대 액수는 131만원이다. 이밖에 보청기 구입부터

news.joins.com

③ 현실적 대안 부족

- 청각장애인이 현실적으로 요구하는 항목에 부합하는 제품이 거의 없다.

- 실제 사례) 화재경보기 설치 현황

"청각장애인용 경보장치, 모든 건물에 설치 의무화 해야" - 비마이너

청각장애인용 재난 경보장치를 모든 건축물에 의무적으로 설치해야 한다는 주장이 제기되었다. '(가)장애의 벽을 허무는 사람들(아래 장벽허사)'은 지난 6일 경기도 화성에서 발생한 화재로 60대

www.beminor.com

1.2 목표 정의

청각장애인을 위한 사용자 맞춤형 소리 알림 어플리케이션 ‘소리미’ 제안

- 스마트폰 진동 알림 어플을 구현함으로써 청각장애인들이 느끼는 청각 보조기구의 가격에 대한 부담을 줄이고, 사용방법이 간단하며, 인식하고 싶은 소리를 사용자가 직접 선택하여 원하는 알림을 받을 수 있도록 함

1.3 범위 정의

프로젝트의 범위를 정의함으로써 프로젝트의 상세한 윤곽을 잡아보고, 추후 해당 주제를 벗어나지 않도록 미리 범위를 정의해두고 시작했다. 실제로 본 시스템을 구현할때, 사용자가 누구인지, 왜 이 시스템을 개발해야 하는지 헷갈리거나 범위를 벗어난 생각을 하는 경우가 종종 생겼는데 범위 설정을 해두어서 주제를 다시 다잡고 팀 회의를 진행하는 좋은 역할을 해주기도 하였다.

2. 설계 및 구현

2.1 프로젝트 설계

2.1.1 Activity Diagram

Activity Diagram을 그려봄으로써 프로그램의 프로세스에 대한 구체적인 정의를 하고, 설계에 대한 대략적인 그림을 그려보았다.

2.1.2 AS-IS, TO-BE 분석

AS-IS, TO-BE 분석을 통해 본 시스템 구현을 통해 어떤 점이 해결되는지, 기존 시스템에 대한 문제를 파악해보는 시간을 가졌다.

① AS-IS 분석 및 문제 정의

② TO-BE 분석

2.1.3 User Journey Map

해당 시스템이 구현되었을 때, 사용자가 어떻게 반응하는지에 대한 사용자 경험을 시각화 하여 표현함으로써 본 시스템에 대한 필요성을 더욱 강조했다.

이 user journey map을 살펴보아도, 사용자의 니즈가 매우 다양함을 알 수 있다. 이 모든 사용자의 니즈를 충족시켜주는 시스템인 사용자 맞춤형 서비스를 제공하여 Installed Base를 확보하는 것을 최종 목표로 두었다.

2.2 프로젝트 구현

2.2.1 데이터 수집

두가지의 데이터 셋을 사용했다.

| FSD Kaggle 2018 | Kaggle 대회를 위해 Google AudioSet에서 발췌한 데이터셋으로, 18873개의 사운드 데이터를 41개의 클래스로 라벨링한 데이터 |

| Urbansound8K | 도시 영상에서 추출한 사운드로 구성된 데이터셋으로, 8732개의 사운드 데이터를 10개의 클래스로 라벨링한 데이터 |

여기에 있는 모든 데이터를 사용하지는 않았고, 프로젝트 주제에 적합한 8개의 클래스만 일부 추출하여 사용했다.

클래스 불균형 방지를 위해 아래 클래스에서도 너무 많은 데이터를 보유한 데이터의 경우도 최대 500개의 데이터만 사용했다. 따라서 총 8개의 클래스로 라벨링 된 2721개의 사운드 데이터를 활용했다.

| 사용된 8개의 클래스 | Knock, Cough, Meow, Chime, Engine_idling, Dog-bark, Siren, Car-horn |

print(metadata.class_name.value_counts())

2.2.2 데이터 형태 시각화

소리 데이터는 모든 형태와 파형이 다양하기 때문에 시각화하여 그 모습을 살펴보았다.

filename = 'c:/code/dataset/kaggle_sample/00fbb28b.wav'

plt.figure(figsize = (12, 4))

data.sample_rate = librosa.load(filename)

_ = librosa.display.waveplot(data, sr = sample_rate)

2.2.3 데이터 속성 분석

① Audio Channels

- 오디오는 스테레오, 모노 두 가지의 타입으로 존재

- 스테레오는 두개의 채널, 모노는 한 개의 채널을 가짐

- 수집데이터는 두 가지의 타이이 혼재되어 있는 형태로 보임

② Sample Rate

- 이산적인 신호를 만들기 위해서 연속적인 신호에서 얻어진 단위당 (주로 초) 샘플링 횟수

- 수집데이터의 Sample Rate는 96K ~ 11K로 다양

print(audiodf.sample_rate.value_counts(normalize = True))

③ Bit Depth

- 오디오를 세분화하여 표현하는 정도, 비트의 심도라고 부름.

- 수집 데이터의 Bit Depth 또한 매우 다양하게 분포함.

print(audiodf.bit_depth.value_counts(normalize = True))

2.2.4 데이터 전처리

① 하나의 채널로 통합

- 스테레오 타입의 데이터를 두 채널의 평균값을 이용하여 하나로 병합하고, 모노 타입으로 변환해 주었다.

import matplotlib.pyplot as plt

# 원래 original 데이터의 형태

plt.figure(figsize=(12, 4))

plt.plot(scipy_audio)

# 합쳐진 채널

plt.figure(figsize=(12, 4))

plt.plot(librosa_audio)

② Sample Rate 값들의 표준화

- 다양하게 분포했던 Sample Rate 값들을 표준화 시켜주는 작업을 수행했다.

- Sample-rate conversion 기술을 활용하여 다양한 Sample Rate들을 표준화 시켰다.

- Sample-rate conversion? 이산신호의 샘플링 속도를 변경하여 기본 연속 신호의 새로운 이산 표현을 얻는 과정

- Librosa 모듈의 load 기능을 이용하여 데이터들의 Sample Rate를 22.05KHz로 변환했다.

- librosa.load(filename, sr=None) 이 형태, sr을 None으로 설정해주지 않으면 자동으로 resampling이 진행됨

- 본 프로젝트에서는 지정해주지 않았기 떄문에 resampling이 진행됐음을 알 수 있음.

- resampling된 데이터의 분포는 -1과 1사이로 정규화됨

- 참고링크

import librosa

from scipy.io import wavfile as wav

import numpy as np

filename = 'UrbanSound_Dataset_sample/audio/102857-5-0-0.wav'

librosa_audio, librosa_sample_rate = librosa.load(filename)

scipy_sample_rate, scipy_audio = wav.read(filename)

print('Original sample rate:', scipy_sample_rate)

print('Librosa sample rate:', librosa_sample_rate)

③ Bit Depth 값들의 정규화

- librosa 모듈의 load 기능을 이용하여 각 데이터들의 Bit Depth를 -1 과 1 사이의 값을 갖도록 정규화 시켜주었다.

print('Original audio file min~max range:', np.min(scipy_audio), 'to', np.max(scipy_audio))

print('Librosa audio file min~max range:', np.min(librosa_audio), 'to', np.max(librosa_audio))

2.2.5 데이터 특성 추출

소리데이터는 다른 비정형 데이터와는 다르게 주파수 및 시계열의 특성을 모두 분석한 feature가 필요했다. 여러번의 실패를 맛보고, 팀원들과 열심히 공부한 결과 MFCC 앍리즘을 활용해서 Feature를 추출해주어야 한다는 점을 알게 되었다. MFCC 에 대한 자세한 포스팅은 나중에 하도록 하고, 프로젝트에 필요한 간단한 지식과 간단한 코드를 구현하여 본 프로젝트를 마저 업로드 해보겠다.

- MFCC (Mel-Frequency Cepstral Coefficients)

- 소리데이터를 일정 구간으로 나누어 해당 구간에 대한 스펙트럼을 분석하여 특징을 추출해주는 대표적인 음성인식 알고리즘

- 음정이 변해도 MFCC가 일정하게 유지되기 때문에 활용범위가 상당히 넓음을 알 수있다.

- 소리의 주파수 및 시간의 특성까지 모두 분석해준다.

- 소리는 시계열 데이터이기 때문에 시간의 특성까지 분석이 필요했고, 주변의 일정하지 않은 소리를 인식하고, 음정이 달라도 같은소리로 인식해주어야 하기 때문에 MFCC 알고리즘을 사용해보기로 한다.

import librosa

import numpy as np

import pandas as pd

import os

max = 0

def extract_features(file_name):

try:

audio, sample_rate = librosa.load(file_name, res_type='kaiser_fast')

mfccs = librosa.feature.mfcc(y=audio, sr=sample_rate, n_mfcc=40)

# print(mfccs.shape) # 이거 추가해봄

mfccsscaled = np.mean(mfccs.T,axis=0)

global max

if mfccs.shape[1] > max:

max = mfccs.shape[1]

# print(max)

except Exception as e:

print("Error encountered while parsing file: ", file_name)

return None

return mfccsscaled

# 데이터셋 path 지정

fulldatasetpath = 'C:/code/cap_sound/dataset/final_dataset_500/'

metadata = pd.read_csv('C:/code/cap_sound/dataset/final_500.csv')

features = []

# 각 소리에 대해 feature를 추출

for index, row in metadata.iterrows():

file_name = os.path.join(os.path.abspath(fulldatasetpath)+'/'+str(row["slice_file_name"]))

class_label = row["class_name"]

data = extract_features(file_name)

features.append([data, class_label])

# df로 만들기

featuresdf = pd.DataFrame(features, columns=['feature','class_label'])

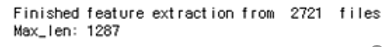

print('Finished feature extraction from ', len(featuresdf), ' files')

print('Max :',max)

요약해서 추출된 feature를 살펴보면

mfccs = librosa.feature.mfcc(y = librosa_audio, sr = librosa_sample_rate, n_mfcc = 40)

print(mfccs.shape)

import librosa.display

librosa.display.specshow(mfccs, sr = librosa_sample_rate, x_axis = 'time')

2.2.6 모델 구축

배운 지식을 활용해보고자 세 가지의 모델을 구축했고, 각 모델 별 Accuracy를 보고 최종 모델을 결정하였다.

① 데이터 분할 및 저장

- 데이터 변환 및 라벨 인코더 적용

- Sklearn의 labelEncoder를 적용했다.

- 범주형 텍스트 데이터를 이해할 수 있는 수치형 데이터로 변환하기 위해서

from sklearn.preprocessing import LabelEncoder

from keras.utils import to_catagorical

x = np.array(featuresdf.feature.tolist())

y = np.array(featuresdf.class_label.tolist())

le = LabelEncoder()

yy = to_categorical(le.fit_transform(y))

② 데이터 분할

- sklearn의 train_test_split을 적용하여 train:test = 8:2로 분할했다.

from sklearn.model_selection import train_test_split

x_train, x_test, y_train, y_test = train_test_split(X, yy, test_size = 0.2, random_state = 42)

2.2.6.1 MLP (Multi-Layer Perception)

- 모델 선정 이유

- 신경망의 기본이 되는 모델로서, 입력층, 은닉층, 출력층의 단순한 구조로 구현이 용이하여 학습 소요시간이 짧으므로 채택

- 지도학습이 필요한 문제를 해결하는데 주로 사용되며, 음성인식 혹은 이미지 인식에서 주로 사용되기 때문에 사용

- 모델 구현

import numpy as np

from keras.models import Sequential

from keras.layers import Dense, Dropout, Activation, Flatten

from keras.layers import Convolution2D, MaxPooling2D

from keras.optimizers import Adam

from keras.utils import np_utils

from sklearn import metrics

num_labels = yy.shape[1]

filter_size = 2

# Construct model

model = Sequential()

model.add(Dense(256, input_shape=(40,)))

model.add(Activation('relu'))

model.add(Dropout(0.5))

model.add(Dense(256))

model.add(Activation('relu'))

model.add(Dropout(0.5))

model.add(Dense(num_labels))

model.add(Activation('softmax'))- 완전 연결 계층 3층으로 구성

- 활성화 함수는 각 layer 마다 ReLU, ReLU, softmax 함수를 사용

- Batch 256 / epoch 는 100, 150,,,, 1000 까지 다양하게 학습 진행

- 학습 진행

from keras.callbacks import ModelCheckpoint

from datetime import datetime

num_epochs = 1000

num_batch_size = 32

# 얘 원래 있는 모델을 쓰는게 맞는지

checkpointer = ModelCheckpoint(filepath='C:/code/cap_sound/save_models/weights.best.basic_mlp.hdf5',

verbose=1, save_best_only=True)

start = datetime.now()

model.fit(x_train, y_train, batch_size=num_batch_size, epochs=num_epochs, validation_data=(x_test, y_test), callbacks=[checkpointer], verbose=1)

duration = datetime.now() - start

print("Training completed in time: ", duration)- 실행결과 학습시간이 매우 짧다는 장점이 있었음. (epoch 1000 일때 학습 소요 시간 약 38초)

- 전처리 및 MFCC 를 적용한 데이터를 따로 변형없이 바로 사용 가능하다는 점이 편리했음.

2.2.6.2 CNN (Convolutional Nural Network)

- 모델 선정 이유

- 본질적으로는 단순한 MLP의 확장이지만, 입력층, 컨볼루션층, 폴링층, 완전연결계층이 결합된 형태로 대부분의 경우 MLP보다 더 좋은 성능을 발휘하기에 채택

① 데이터 전처리, 특징 추출, 제로패딩 수행

# extract feature 함수 재정의

import numpy as np

max_ped_len = 1287

test_num = 0

def extract_features(file_name):

try:

audio, sample_rate = librosa.load(file_name, res_type = 'kaiser_fast')

mfccs = librosa.feature.mfcc(y=audio, sr = sample_rate, n_mfcc = 40)

pad_width = max_pad_len - mfcc.shape[1]

mfccs = np.pad(mfccs, pad_width = ((0, 0), (0, pad_width)), mode = 'constant')

except Exception as e:

print("Error 발생: ", file_name)

return None

return mfccsimport pandas as pd

import os

import librosa

fulldatasetpath = 'C:/AI/final_dataset_500/'

metadata = pd.read_csv("C:/AI/final_500.csv')

features = []

for index, row in metadata.iterrows():

file_name = os.path.join(os.path.abspath(fulldatasetpath) + '/' + str(row["slice_file_name"]))

class_label = row['class_name']

data = extract_features(file_name)

features.append([data, class_label])

featuresdf = pd.DataFrame(features, columns = ['feature', 'class_label'])

print("Finished feature extraction from ', len(featuresdf), ' files')

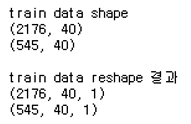

② 학습 데이터 reshape

num_rows = 40

num_columns = 1287

num_channels = 1

prnt("train data shape")

print(x_train.shape)

print(x_test.shape)

x_train = x_train.reshape(x_train.shape[0], num_rows, num_columns, num_channels)

x_test = x_test.reshape(x_test.shape[0], num_rows, num_columns, num_channels)

print("\ntrain data reshape 결과")

print(x_train.shape)

print(x_test.shape)

③ 모델 구현

import numpy as np

from keras.models import Sequential

from keras.layers import Dense, Dropout, Activation, Flatten

from keras.layers import Convolution2D, MaxPooling2D, GlobalAveragePooling2D

from keras.optimizers import Adam

from keras.utils import np_utils

from sklearn import metrics

num_labels = yy.shape[1]

filter_size = 2

#CNN모델 구현

model = Sequential()

model.add(Conv2D(filters = 16, kernel_size = 2, input_shape = (num_rows, num_columns, num_channels), activation = 'relu'))

model.add(MaxPooling2D(pool_size = 2))

model.add(Dropout(0.2))

model.add(Conv2D(filters = 32, kernel_size = 2, activation = 'relu'))

model.add(MaxPooling2D(pool_size = 2))

model.add(Dropout(0.2))

model.add(Conv2D(filters = 64, kernel_size = 2, activation = 'relu'))

model.add(MaxPooling2D(pool_size = 2))

model.add(Dropout(0.2))

model.add(Conv2D(filters = 128, kernel_size = 2, activation = 'relu'))

model.add(MaxPooling2D(pool_size = 2))

model.add(Dropout(0.2))

model.add(GlobalAveragePooling2D())

model.add(Dense(num_labels, activation = 'softmax'))

#컴파일

model.compile(loss = 'categorical_crossentropy'

, metrics = ['accuracy']

, optimizer = 'adam')

model.summary()

score = model.evaluate(x_test, y_test, verbose = 1)

accuracy = 100 * score[1]

print('Pre-training accuracy: %.4f%%' % accuracy)- 모델 설명

- 4개의 convolution 계층과 4개의 Max pooling 계층으로 구성

- 각 layer의 활성화함수는 ReLU함수, 출력층은 softmax함수를 이용

- drop out 값은 0.2

- 학습 진행

- batch 256

- epoch는 100, 150,,, 1000 까지 다양하게 수행해봄

- 특이사항

- CNN모델에서는 인풋 데이터의 크기가 (3차원)으로 모두 동일해야함

- 그러나 MFCC 전처리가 적용된 데이터의 경우 다음과 같으 모두 다양한 shape을 보유하기에 모두 동일한 형태로 reshape이 따로 필요했음.

- 따라서 max len = 1287로 제로패딩을 수행해주었음.

- 결론적으로 데이터 shape는 아래 표 처럼 변화함

2.2.6.3 LSTM (Long Short-Term Memory)

- 모델 선정 이유

- RNN의 약점으로 지적되는 Vanishing Gradient Problem을 개선한 모델로, 대부분의 경우에서 RNN보다 좋은 성능을 보이므로 채택

① 학습데이터 reshape

print("train data shape")

print(x_train.shape)

print(x_test.shape)

#x_train=x_train.reshape(2176,40,1)

x_train = np.reshape(x_train, (len(x_train), len(x_train[0]), -1))

x_test = np.reshape(x_test, (len(x_test), len(x_test[0]), -1))

#print(y_train.shape)

#print(y_test.shape)

print("\ntrain data reshape 결과")

print(x_train.shape)

print(x_test.shape)

② 모델 구현

import numpy as np

from keras.models import Sequential

from keras.layers import Dense, Dropout, Activation, Flatten

from keras.layers import Convolution2D, Conv2D, MaxPooling2D, GlobalAveragePooling2D

from keras.layers import GRU, LSTM, Embedding # RNN

from keras.optimizers import Adam

from keras.utils import np_utils

from sklearn import metrics

num_labels = y_train.shape[1]

#LSTM 모델 구현

model = Sequential()

model.add(LSTM(256,input_shape=(40,1),return_sequences=False))

model.add(Dense(512, activation='relu'))

model.add(Dropout(0.2))

model.add(Dense(512, activation='relu'))

model.add(Dropout(0.2))

model.add(Dense(512, activation='relu'))

model.add(Dropout(0.2))

model.add(Dense(512, activation='relu'))

model.add(Dropout(0.2))

model.add(Dense(512, activation='relu'))

model.add(Dropout(0.2))

#model.add(TimeDistributed(Dense(vocabulary)))

model.add(Dense(num_labels, activation='softmax'))

model.compile(loss='categorical_crossentropy', metrics=['accuracy'], optimizer='adam')

# Display model architecture summary

model.summary()

- 모델 설명

- LSTM 모델에 완전연결계층 5개 연결

- 각 계층에서 ReLU함수, 출력계층에서 softmax함수를 사용

- 5개의 Dense

- drop out 0.2

- 다음과 같이 학습 진행

- Batch 256

- epoch는 100, 150,,,,, 1000 까지 다양하게 진행해봄

- 특이사항

- LSTM모델을 자연어 처리에 사용시, 인풋데이터를 숫자 형태로 변환하기위해 주로 원-핫인코딩을 적용한다.

- 앞서 MLP모델에서 정의한 전처리함수 (Extract_feature) 에서 MFCC적용을 통해 인풋데이터를 숫자로 변환하였기에 별도의 인코딩은 진행하지 않았다. 다만, 데이터의 shape만 살짝 바꾸어 주었다.

2.2.7 모델 정확도 비교 및 모델 선택

MLP, CNN, LSTM 각각 epoch 300, eopch 300, eopch 600에서 accuracy 가 가장 높게 나타났다. 정확도는 CNN > MLP > LSTM 순으로 높았고, 학습 시간은 MLP, LSTM, CNN 순으로 짧았다. LSTM은 정확도가 85% 미만이고, 학습시간은 MLP 대비 길기 때문에 모델 채택에서 제외하고, 성능이 좋지만 시간이 오래걸리는 CNN과 성능이 다소 떨어지지만 학습시간이 짧은 MLP 중에 모델을 선택하기로 한다.

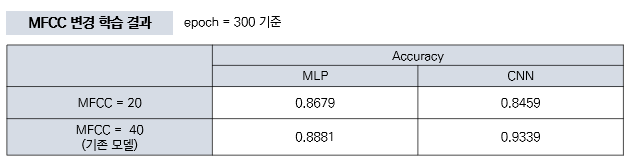

2.2.7.1 MFCC 변경

교수님께서 인풋 데이터의 길이가 긴 경우와 짧은 경우의 것중 어느 것이 더 정확도가 높을지에 대한 추가 연구가 필요할 것이라는 의견을 주셧다. 따라서 MFCC 의 프레임 길이를 변경해서 모델 학습을 진행해보기로 했다.

일반적으로 MFCC에서는 이 프레임의 길이가 20~40ms 정도이다. 프레임의 길이가 너무 길면 주파수 분석에서 신뢰도가 떨어진다. 또한 프레임의 길이가 너무 짧으면 한 프레임 내 신호 변화가 커지기 떄문에 좋지 않았다. 가장 좋은 모델 MLP 와 CNN 모델 중, MFCC 길이의 값을 변경해서 또 학습을 진해해 보았다. MFCC=20일때와 MFCC=40일때의 모델을 비교하여 최종 모델을 선택할 것이다.

모델 학습 결과, 우리 팀의 최종 모델은 MFCC = 40 일때, CNN모델을 사용하기로 했다.

2.2.8 결과 예시

최종 선택된 모델로 소리를 분류해 보겠다.

def print_prediction(file_name):

prediction_feature = extract_feature(file_name)

predicted_vector = model.predict_classes(prediction_feature)

predicted_class = le.inverse_transform(predicted_vector)

print("The predicted class is:", predicted_class[0], '\n')

predicted_proba_vector = model.predict_proba(prediction_feature)

predicted_proba = predicted_proba_vector[0]

for i in range(len(predicted_proba)):

category = le.inverse_transform(np.array([i]))

print(category[0], "\t\t : ", format(predicted_proba[i], '.32f') )filename = 'UrbanSound Dataset sample/audio/100648-1-0-0.wav'

print_prediction(filename)

자동차 소리를 무사히 자동차 소리라고 분류할 수 있었다!!

filename = '../Evaluation audio/siren_1.wav'

print_prediction(filename)

다른 데이터셋을 사용해도 무사히 사이렌 소리를 사이렌 소리로 구별할 수있었다.

우리팀은 일정 소리으

2.2.9 프로토타입 제작

우리의 주제는 애초에 '어플리케이션'이지만, 제한 시간 이내로 안드로이드와 Java를 숙련시켜 어플리케이션을 실제로 제작하기엔 무리가 있었다. 따라서 우리 팀은 어플리케이션으로 보일 수 있는 exe 파일을 제작하여 프로토타입을 제작학로 하고 프로젝트를 진행했었다. python으로 구현한 모델과 PyQt를 연동시켜 프로토타입을 제작할 수 있었다.

아래 방법으로 프로토타입 제작을 진행했다.

해당 마지막 과정은 내가 참여한 것이 아닌 팀원의 작품이기에 자세한 코드는 첨부하지 않고, 최종 결과물을 업로드 해보겠다.

진짜 어플리케이션은 아니더라도 이렇게 프로토타입으로 제작하여 실생활에서 어떻게 사용될지 직접 구현하여 발표한 점이 학술대회 금상 수상에 가장 큰 영향을 끼친 것이 아닐까 생각했다. 보통 코드를 통해 소리를 input해서, out되는 결과값을 보여주는 분류의 가능성을 보여주었는데, 우리 팀은 실제로 소리를 들려주고, 이를 분류하는 과정까지 동영상을 통해 보여주면서 많은 사람들에게 인정 받을 수 있었던 것 같다.

사용자가 소리를 선택하고, 해당 소리에 원하는 진동패턴을 선택할 수 있도록 만들었다. 또한 청각장애인이 촉각으로 소리를 느낄 수 있도록 진동으로 구현하고자 했지만, 발표라는 특성상 프로토타입의 청각 및 시각적인 효과를 위해 삐--- 소리를 이용해서 구현해 보았다.

3. 기대효과 및 추후 연구 방향

- 기대효과

- 범죄 발생률이 높은 지역에 기기를 설치하여 방법용으로 사용 가능

- 이어폰 착용중에도 차 경적 및 엔진소리를 감지하는 알림을 주는 어플리케이션으로 발전 가능

- 청각장애인을 위한 시설 비용을 절감할 수 있음

- 소리를 듣지 못해서 생기는 위험을 방지할 수 있음.

- 맞춤형 소리 분류 시스템으로 삶의 질 향상 가능

- 제조 산업에서의 위험 사고 발생 감지, 게임 산업에서의 음성인식, ott 등 미디어 산업에서의 음성 인식, 금융업에서의 챗봇 등 다양한 산업에서의 발전 가능성이 무한히 존재함

- 한계 및 추후 연구 방향

- 소리 분류의 정확도는 주변 상황에 따라 달라질 수 있기에 노이즈 관련 연구가 추가로 진행이 필요하다.

- 소리를 탐지하는 마이크의 성능도 중요하게 작용한다.

- 감지해야할 소리가 동시다발적으로 발생하면, 모든 소리를 인식하기 힘들다는 한계가 존재한다.

- 따라서 동시다발적으로 발생하는 소리에 대한 처리를 위한 모델 성능 개선이 필요하다.

- 소리의 종류를 늘려서 제조, 공정, 디지털 헬스케어, 금융, 게임 등 다양한 산업에서 사용 가능하도록 연구가 필요하다.

마치며 ... :)

길고 긴 포스팅이 끝났다. 마지막에 어플리케이션을 완벽하게 구현하지못했지만, 이렇게라도 AI가 산업에 어떻게 적용되어 사용되고, 어플리케이션에 어떤 기능으로 적용되는지에 대해서 공부해볼 수 있었다. PyQt 툴도 신선했고, 이를 통해 간단한 프로그램을 구현할 수 있다는 점도 신선했다.

마지막으로,,, 진짜 약 3개월간의 고생끝에 모든 선배들, 모든 팀들을 제치고 수상한 상장 사진을 마지막으로 포스팅 마무리짓겟다!!!!!!!!!!! 행복했따!!!!!!!!!!

노력은 배신하지 않는다 :)

'AI study > potato's PJT (in dongguk)' 카테고리의 다른 글

| [추천시스템] Song2Vec을 활용한 개인 맞춤형 음원 추천 시스템 개발 (0) | 2021.07.28 |

|---|---|

| [추천시스템] 영화 평점 데이터로 협업필터링 추천시스템 (Collaborative Filtering) 구현 (2) | 2021.04.29 |

| [Data Science] 미식축구 경기 네트워크 분석 및 링크 예측 (0) | 2021.04.29 |

| [NLP] 특허 데이터로 Topic Modeling을 진행해보자 (0) | 2021.04.29 |

| [Data Science] TM(텔레마케팅)이 상품가입으로 이어지는 고객군 분석 (0) | 2021.04.28 |